Международное военно-правовое обозрение

18:46 | 8 апреля 2019 г.

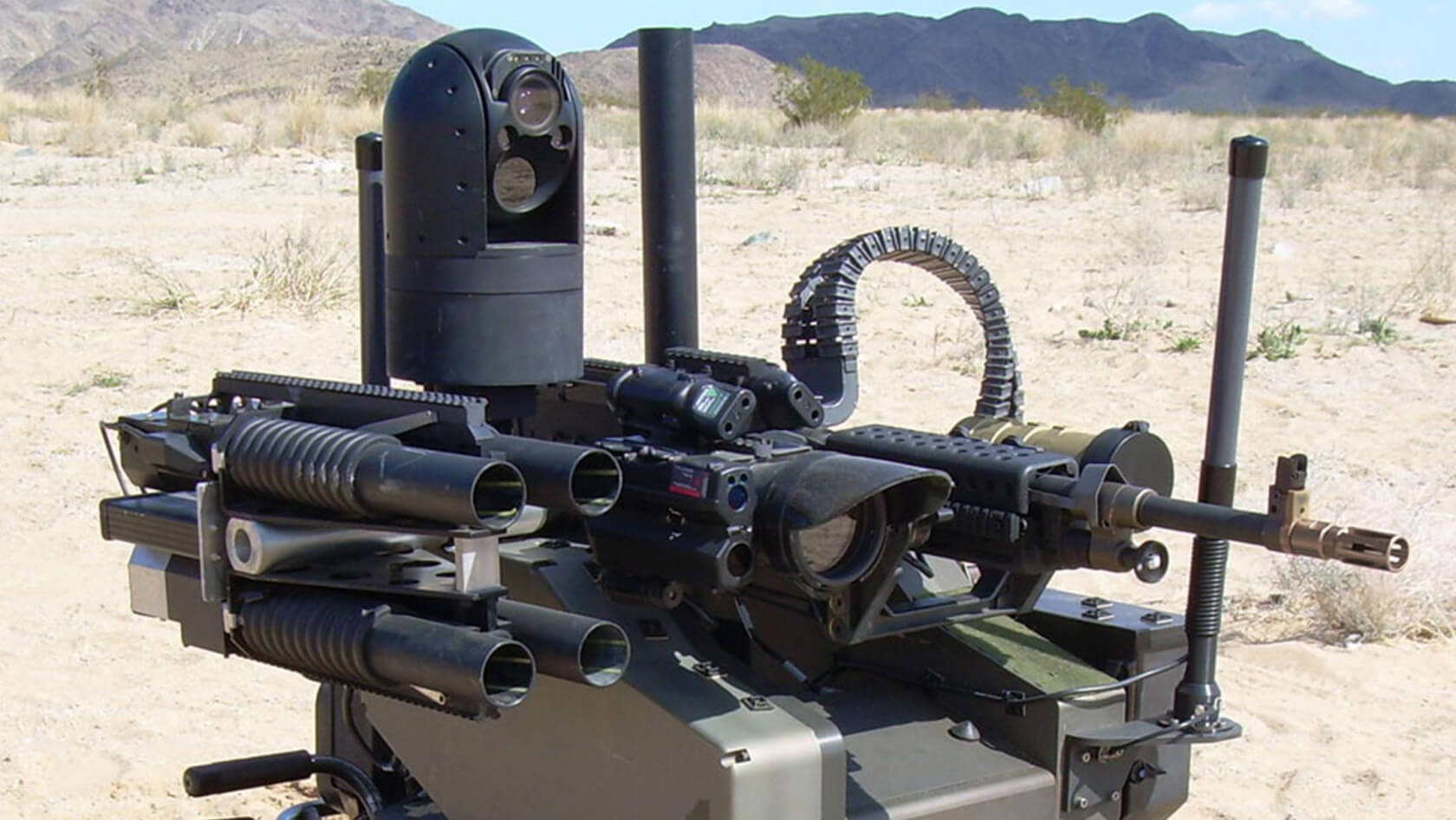

Роботы-убийцы страшнее ядерной войны: почему создание автономных боевых систем предлагают запретить на международном уровне

Около 80 стран мира сейчас разрабатывают или уже выпускают боевых роботов. И хотя умеющих действовать полностью самостоятельно смертоносных машин пока не так много, военные аналитики предрекают: мы в одном шаге от появления автономных боевых систем. В марте прошло сразу две международных конференции, где речь шла о необходимости контроля над созданием роботов-убийц, примерно такого же, как и в случае с ядерным оружием. «Армейский стандарт» изучил степень новых угроз.

Не так давно министр армии США Марк Эспер заявил, что оборонное ведомство планирует потратить 182 миллиарда долларов на внедрение в американских вооруженных силах систем, основанных на использовании искусственного интеллекта. Конечно, министр армии — гражданская должность в Министерстве обороны США. Однако полувоенный чиновник несет ответственность практически за все вопросы: людские ресурсы, персонал, формирование резерва, учет зданий и сооружений, охрану окружающей среды, разработку систем вооружения и оборудования, их приобретение, а также за коммуникации и финансовое управление.

Так вот, Эспер убежден: «Тот, кто первым получит военный искусственный интеллект, долгие годы будет доминировать на полях сражений. Конечно, это должны быть наши солдаты, которые с его помощью смогут думать и действовать намного быстрее!»

Сомневаться в том, что страна, обладающая боевыми роботами, будет иметь военное превосходство над страной, их не имеющей, не приходится. И здесь есть два аспекта — социальный и экономический.

Социальный очевиден: на поле боя благодаря роботам не гибнут свои солдаты или гибнут значительно меньше. Именно поэтому еще в 1930-х годах в Советском Союзе испытывали телеуправляемые танки, танкетки и даже торпедные катера. К сожалению, тогда до массового применения дело не дошло.

Сейчас же роботы активно внедряются во всех странах мира. Это и роботы-саперы (например, российский «Уран»), и роботы-разведчики, и различные платформы, способные вести огонь. И, конечно, беспилотные летательные аппараты.

Экономический аспект проще всего рассмотреть как раз на примере беспилотных летательных аппаратов. Сейчас летающие дроны нуждаются в дорогостоящих пунктах управления, хорошо подготовленных операторах, помехозащищенной связи. И это едва ли не главная статья расходов. Беспилотники, способные сами в полете принимать решения, станут в разы дешевле, и их можно будет штамповать большими сериями без роста затрат.

Конечно, в любом случае существует опасность кибервмешательства и перехвата управления. И тогда оружие может быть направлено против страны-владельца.

В относительно недавней истории есть подобный инцидент. В 2007 году в армии ЮАР в ходе учений применялась автоматическая противовоздушная 35-мм скорострельная пушка швейцарско-немецкого производства Oerlikon GDF-005 («Эрликон»). Она оснащена активным и пассивным радарами, лазерной системой целеуказания и может вести огонь по быстрым низколетящим целям. Сначала пушка несколько раз выходила из строя, а в какой-то момент включилась и принялась вести беспорядочный огонь по всему вокруг до тех пор, пока не закончился боекомплект. В результате погибли 9 военнослужащих армии ЮАР, еще 14 получили ранения. Военный представитель сообщил, что причины ЧП остались неизвестны. Но ряд экспертов указывали на компьютерный сбой.

Именно в посыле «самостоятельно принимать решения» и кроется главная опасность, считают многие эксперты.

Осенью 1983 года советская автоматическая система предупреждения о ядерном нападении выдала серию сигналов о пусках баллистических ракет с территории США. К счастью, оперативный дежурный проанализировал «пуски»: все они были зафиксированы из одной точки. Это позволило опознать ошибку автоматики и не допустить нанесения ответного удара. По большому счету мир был на грани ядерной войны. И неизвестно, были бы мы сейчас живы, если бы система была полностью автономной и сама могла принимать решения.

Тем не менее разработки военного искусственного интеллекта все равно ведутся. Самой известной, пожалуй, является полностью автономный израильский беспилотник Harpy («Гарпия»). После запуска он в полностью автоматическом режиме ищет и уничтожает своими ракетами вражеские радары в режиме «выстрелил-забыл».

Южная Корея разрабатывает робота для патрулирования границы с Северной Кореей. Военный эксперт Алексей Леонков неоднократно упоминал о том, что перспективные крылатые ракеты, действующие «стаей», способны обмениваться между собой информацией и самостоятельно назначать себе цели при заходе в район поражения.

Проще говоря, современное состояние вооружений таково, что остался всего шаг до появления высокоавтоматизированных систем, которые сами будут решать, кого убивать, а кого нет.

Именно об этом шла речь на международной конференции «Capturing Technology. Rethinking Arms Control», организованной недавно МИД Германии. В ней приняли участие не только страны НАТО, но и представители Китая, Индии, Японии, а также нашей страны.

Все участники сошлись во мнении, что даже при современном уровне технологий фантастические сценарии о вышедших из-под контроля «терминаторах» могут обрести реальность. Например, министр иностранных дел Германии Хайко Маас сказал: «Новые технологии вместе с новыми возможностями несут нам и новые опасности… Они действительно могут выйти из-под контроля. Поэтому вопрос стоит так: либо мы овладеем ими, либо они — нами! Миру, входящему в эру гораздо более опасных вооружений, нужны новая международная ответственность и новое мышление».

Также говорилось и о необходимости развивать в целом новую архитектуру контроля над вооружениями, которая включала бы в себя «не только ядерное оружие, но и современные автономные боевые системы, которые убивают полностью без контроля человека, как, например, роботы-убийцы».

Основная задача, которая была определена на конференции, — установление «красных линий», переход которых при разработке автоматизированных боевых систем будет недопустимым.

Например, организаторы объявленной несколько лет назад международной «Кампании за запрет убивающих роботов» считают, что главная проблема заключается в том, что боевые машины несовершенны и не в состоянии отличить мирного гражданина от террориста. А в современном мире войны часто ведутся в таких местах, где всего один случайный выстрел может привести к эскалации насилия.

В то же время есть и другая концепция, автором которой является профессор из Института технологии в Атланте Рональд Аркин. В его концепции боевая система управляется так называемым «этическим контролером» — она запрограммирована на соблюдение правил ведения боевых действий и принципов международного права. Ужасные вещи на поле боя совершают сами люди, считает профессор.

Как бы там ни было, но всем уже стало очевидно, что такие системы создают реальную гуманитарную и этическую проблему.

Кроме того, в конце марта в Женеве прошли международные консультации по тематике «роботов-убийц». С инициативой по разработке международного режима контроля за автономными роботизированными боевыми системами там выступили Бельгия, Люксембург и Ирландия. В частности, было предложено нацелить международные ограничения против «автономных вооружений, способных убивать без какого-либо вмешательства человека».

Впрочем, сами участники консультаций отмечают, что до введения запретов еще далеко. Поскольку для начала придется выработать «международное определение того, что представляет собой система автономного летального оружия».

Учитывая, что в современном мире договоренности достигаются долго, а вот договоры рвутся быстро, чему пример — Договор о РСМД, не исключено, что опасность «восстания машин» ближе, чем кажется.

Билл Гейтс, основатель империи «Майкрософт», на конференции Стэнфордского института антропоцентрического искусственного интеллекта недавно предрек: «Искусственный интеллект по потенциальным негативным последствиям его применения в военной сфере сравним разве что с ядерным оружием. Если человечество не «переключит» его использование на такие действительно полезные сферы, как медицина и образование, всех нас ждет большая беда!»

Не хотелось бы, чтобы компьютерный гений оказался прав.

По материалам сайта сетевого издания «Армейский стандарт» от 1 апреля 2019 года

Фото: архив сайта "millaw.ru"©

также советуем

17:55 | 15 апреля 2019 г.

Военное сотрудничество стран СНГ в области образования будет развиваться22:26 | 30 июня 2020 г.

Подписан указ о призыве граждан РФ, пребывающих в запасе, на военные сборы в 2020 годусамое популярное

12:09 | 6 июля 2020 г.

С 1 ОКТЯБРЯ ОКЛАДЫ ВОЕННОСЛУЖАЩИХ ПОВЫШАЮТСЯ НА 3 ПРОЦЕНТА23:15 | 30 июня 2020 г.

Актуализирован перечень видов работ, профессий, должностей для прохождения альтернативной службы19:16 | 9 марта 2021 г.

Расширен перечень оснований для назначения военнослужащего на низшую воинскую должность

Комментарии (0)

Только зарегистрированные пользователи могут оставлять комментарии.

Пожалуйста, авторизуйтесь.